¿Por qué Google no indexa el 20% del contenido de páginas web?

«¡Google no indexa mi web!». Probablemente esta sea una de las denuncias más extendidas entre webmasters y especialistas en marketing digital. Se estima que alrededor del 20% de las páginas de web no se indexan en el famoso buscador de Internet, una tasa insignificante para webs de pequeño tamaño, pero que en ecommerces y medios de comunicación con miles de páginas supone una ‘pérdida’ irreparable.

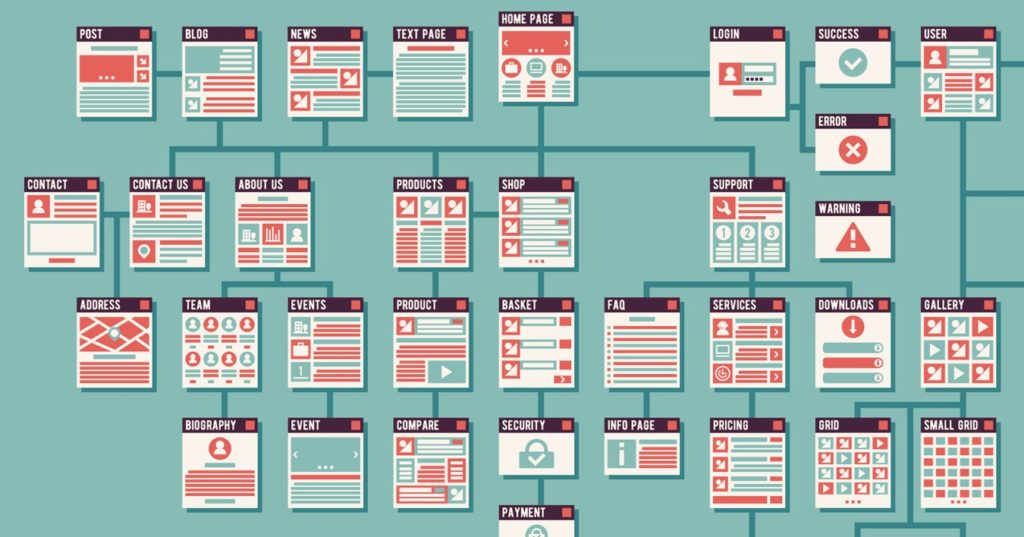

Antes de aparecer en los resultados de búsqueda, las páginas de una web deben agregarse al índice del buscador en cuestión, ya sea Bing, Yahoo! o Google. Este índice es, por utilizar una analogía de Google, similar a una biblioteca que en lugar de libros y manuscritos, contiene páginas web. No hay biblioteca que contenga todos los libros, del mismo modo que no hay buscador que incluya en su índice las casi 2 mil millones de webs (y sus respectivas páginas internas) existentes en la esfera digital.

De vuelta a la cuestión inicial, ¿es normal que un porcentaje tan elevado de páginas sea ignorado por las ‘arañas’ rastreadoras de Google? Para el analista John Mueller, «es completamente normal que no indexemos todo el sitio web. Así que si miras cualquier página grande o incluso de tamaño mediano o pequeño, encontrarás fluctuaciones en la indexación. Subirá y bajará, y nunca se dará el caso de que indexemos el 100% de todo lo que hay en un sitio web. […] Con el tiempo, cuando llegas a unas 200 páginas en tu sitio web y se indexan 180 de ellas, entonces ese porcentaje se reduce un poco. Pero nunca ocurrirá que indexemos el 100% de todo lo que encontremos».

En una videoentrevista publicada en el canal Google Search Central, Mueller ha profundizado en las causas detrás de una tasa de indexación inusualmente baja: ¿el problema reside en la calidad del sitio web o en una sobrecarga de sus servidores? «Probablemente un poco de ambas cosas», aclara el actual Webmaster Trends Analytics del buscador propiedad de Alphabet. «Por lo general, cuando hablamos de webs de pequeño tamaño, [su indexación] no está limitada por la capacidad de rastreo [del buscador], que es el crawl budget asignado. Pero si estamos hablando de un sitio que tiene millones de páginas, entonces es posible que el crawl budget tenga algo que ver. Pero los sitios más pequeños probablemente no [tendrán esta limitación]», continúa Mueller.

La calidad y relevancia del contenido figuran entre los principales factores de posicionamiento en motores de búsqueda y constituyen, en sí mismos, una razón de peso para omitir la indexación de las páginas de una web. Mueller se ha mostrado cauto al respecto, ya que «si tienes cinco páginas que no están indexadas en este momento, no es que esas cinco páginas sean las que consideramos de baja calidad. Es sólo que, en general, consideramos que esas páginas pueden ser de menor calidad que el resto. Y por lo tanto, no vamos a indexarlo todo de este sitio web».

Por otra parte, los aspectos técnicos no influyen tanto como pueda parecer, pues «en su mayor parte, los sitios de hoy en día son técnicamente razonables. Si se utiliza un CMS común, es muy difícil hacer algo realmente malo. Y a menudo es más una cuestión de calidad general», concluye el analista de Google. No obstante, la presencia de irregularidades en los archivos robot.txt y .htaccess puede interferir en la indexación normal de los contenidos, como se desvelará en el siguiente punto.

5 problemas de indexación en Google que lastran tu SEO

Un rápido vistazo a redes y foros vinculados al marketing demuestra que los problemas de indexación no son infrecuentes: «mi web no sale en el buscador de Google», «mi página web no aparece», «busco mi web en Google y no aparece», etcétera. Responsables directos de la dificultad para indexar ciertas páginas en buscadores son los duplicados, las webs de baja calidad e incluso una mala configuración de los archivos robot.txt o .htaccess, por citar una pequeña parte de los factores causantes.

Baja calidad de la página

Garantizar la calidad del contenido en sus resultados de búsqueda es una de las prioridades de Google, cuyos rastreadores pueden ignorar las páginas sin este requisito.

Panda, Colibrí, Bert y otros algoritmos de Google velan por la calidad del contenido indexado y ‘condenan’ al ostracismo los resultados que no cumplen con sus estándares. Pero ¿qué entiende por calidad el gigante de las búsquedas de Internet? La creación de contenido relevante y fidedigno, los enlaces provenientes de fuentes de autoridad, la relevancia de las keywords utilizadas o el enfoque hacia los usuarios (no hacia los robots de búsqueda) ofrecen una idea aproximada del ideal de calidad del buscador de Alphabet.

Según informó Gary Illyes, Standup Trends Analyst de Google Suiza, «todo el contenido [de Internet] debe pasar controles de calidad» y si fracasa, «es posible que Google no lo indexe, incluso si intentas enviar manualmente la página a Google Developers para su indexación». Por lo tanto, la calidad es un atributo básico para que pueda aparecer una página web en Google.

‘Crawl budget’ agotado

Los googlebots tienen una ‘agenda’ muy apretada debido al limitado presupuesto de rastreo que Google les asigna con respecto a cada página web.

El presupuesto de rastreo, o crawl budget, se define como el tiempo asignado a cada página para su rastreo; por así decirlo, es el plazo que Google da a sus ¡arañas’ rastreadoras para analizar cada página web. Que el crawl budget se agote tempranamente es fuente de problemas de indexación en Google, que además asigna este presupuesto de forma selectiva, no igualitaria. La autoridad, la calidad o la velocidad son cualidades que influyen en un mayor o menor crawl budget, y no hace falta decir que un presupuesto mínimo supone un hándicap para los desarrolladores.

(Los interesados encontrarán útil este artículo sobre el presupuesto de rastreo en webs de gran tamaño, publicado en el Centro de la Búsqueda de Google).

Contenido duplicado

Los duplicados constituyen un doble problema, pues además de perjudicar la experiencia de navegación, atraen molestas penalizaciones de Google.

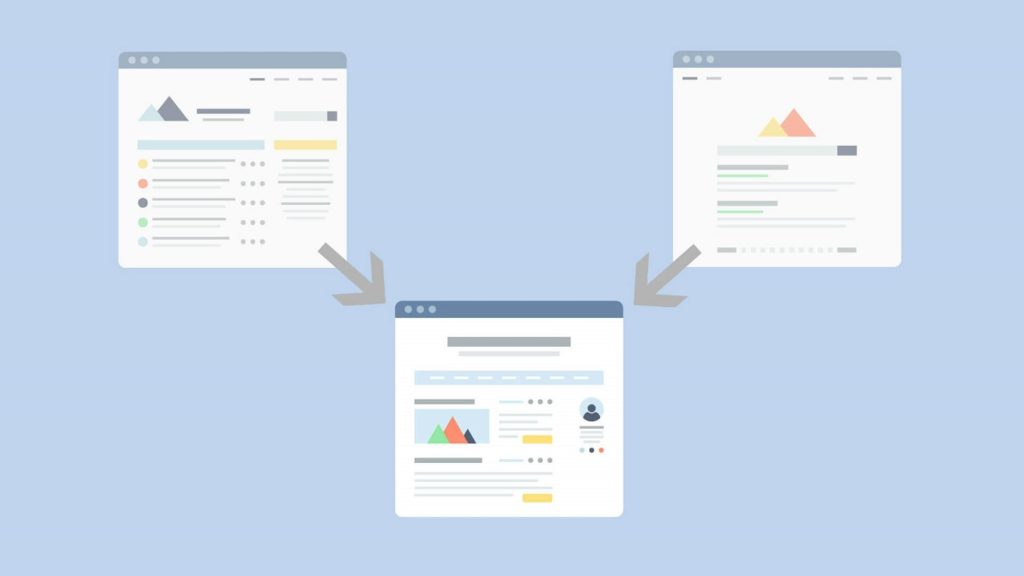

La presencia de duplicados es otra de las razones por las que Google no indexa una web. Un exceso de este tipo de contenido engrosa el número de páginas que el famoso buscador desindexa de sus SERPs o resultados orgánicos de búsqueda. Entre los principales causantes de contenido duplicado, figuran la falta de una URL canonicalizada (‘www.ejemplo.com’ en lugar de ‘ejemplo.com’, o viceversa), las etiquetas y categorías de contenido similar o la presencia de una versión móvil separada del dominio principal (m.ejemplo.com). La refundición de páginas de contenido similar, las redirecciones 301 o el uso de etiquetas Hreflang pueden ser una solución factible.

Mala configuración en el archivo .htaccess o robot.txt

Cuando la URL enviada tiene un problema de rastreo o Google la rechaza sistemáticamente, la causa podría radicar en irregularidades técnicas, como la presencia de bloqueadores en el robot.txt. Este archivo de texto se instala en la raíz del sitio para regular la actividad de las decenas de bots de rastreo que operan para sus respectivos buscadores (Yandex, DuckDuckGo, Ask, AOL, Daum, Dogpile, etcétera, además de los principales).

Dado que su actividad consume un valioso ancho de banda del servidor y puede llegar a colapsarlo, parece lógico limitar el rastreo a los bots de determinados buscadores. Sin embargo, si este archivo contiene el comando ‘disallow’ referido a Google como user agent, esta será la razón por las que gran parte de nuestras páginas no son indexadas. Cambiar el comando ‘disallow’ por ‘allow’ es la solución.

Por otra parte, el archivo .htaccess o acceso de hipertexto puede incluir por defecto o haber sido alterado para bloquear el rastreo a los googlebots. Enmendar esta situación es relativamente fácil, pues este documento, que permanece oculto y ha sido diseñado para agregar funciones extra a las webs alojadas en servidores Apache, puede modificarse accediendo a Cpanel.

Ausencia de sitemap.xml

Los archivos sitemap.xml orientan a las ‘arañas’ rastreadoras de Google durante su labor indexadora.

Después del envío manual de URLs a buscadores y de la optimización on page, la creación de archivos sitemap.xml es el principal recurso para forzar la indexación en Google de cualquier página publicada en un sitio web. Se los denomina también como «mapas web» y se elaboran con el lenguaje marcado extensible, motivo por el que su extensión es .XML.

Pese a su indiscutible utilidad, los archivos sitemap.xml están ausentes en multitud de webs, que ven limitado su posicionamiento SEO al dejar el ‘trabajo sucio’ de la indexación en manos de los googlebots. A menudo las arañas rastreadoras necesitan un documento orientativo, un mapa para localizar las últimas páginas publicadas y conocer su orden de prioridad, y aquí es donde intervienen los archivos sitemap.xml.

Por último, la corrección de estos errores no garantiza una indexación inmediata de las páginas afectadas, ni que el porcentaje de indexación pueda alcanzar el 100%. Con todo, una recomendación general para que Google ‘reconsidere’ la indexación de contenidos rechazados es la herramienta ‘Inspección de URLs’, disponible en el servicio Google Search Console.

Tabla de contenidos